紫东太初全模态大模型来了,一个模型打通感知、认知、决策交互屏障

从单模态、多模态,到全模态,这下一个模型就实现了。

现在,大模型的发展态势已经从单模态迅速转向多模态研究了。就如 Hugging Face 联合创始人 Thomas Wolf 所说的:过去几年里,好的多模态模型一直是许多大型技术实验室的圣杯。不仅如此,多模态也一直被学术界奉为达到通用人工智能的必经之路。就在不久前,OpenAI 的 CEO Sam Altman 透漏出一个重要消息,表明 2024 年 GPT-4 的发展方向也是奔着多模态去的。一时之间,各大科技公司、机构争先入局多模态领域。国外如微软等机构提出可组合扩散模型 CoDi,但这种模型只能同时处理图片、文本、声音、视频 4 种模态,对传感信号、3D 点云等模态还无法处理。在国内,作为早早布局多模态大模型的科研机构,中国科学院自动化研究所自 2019 年开始在语音、文本、图像等单模态大模型研究和应用的基础上,向多模态大模型攻关,并于 2021 年 7 月正式发布了全球首个千亿参数多模态大模型「紫东太初」。今天上午,在人工智能框架生态峰会 2023 上,中国科学院自动化研究所和武汉人工智能研究院推出新一代大模型:全模态大模型「紫东太初 2.0」版本,依托华为全栈国产化软硬件平台昇腾 AI 与开源 AI 框架昇思 MindSpore,「紫东太初 2.0」在文本、图像、语音三模态的基础上,融入 3D 点云、视频、信号等更多模态数据,现已支持多轮问答、文本创作、图像生成、3D 理解、信号分析等全面问答任务,拥有更强的认知、理解、创作能力,带来全新互动体验。实现了真正意义上的任意输入,任意输出。可以说大模型的发展已经从单模态、多模态,进化到全模态赛道上了。中国科学院自动化研究所所长徐波表示:「紫东太初 2.0 全模态大模型是自动化所持续探索可自主进化的通用人工智能道路上的里程碑。」

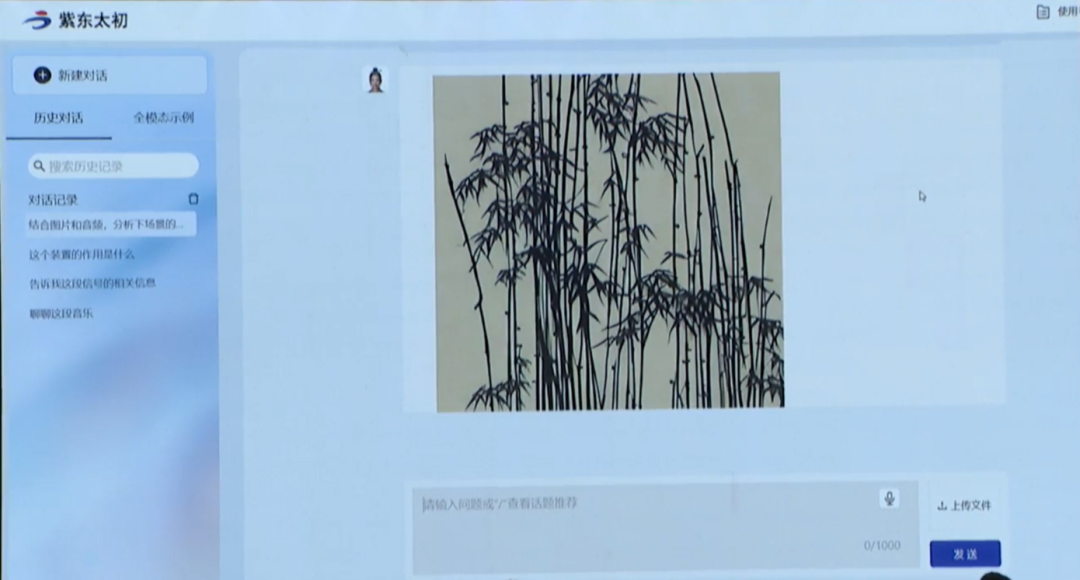

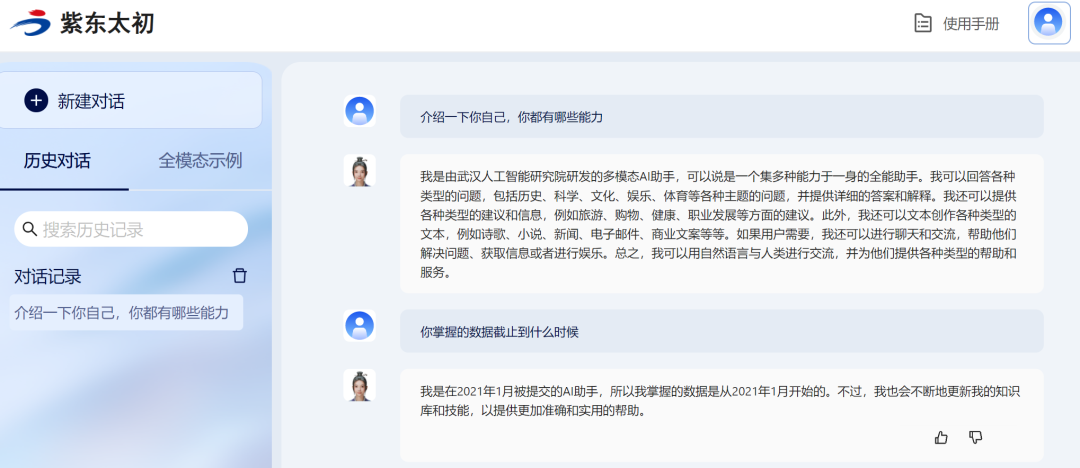

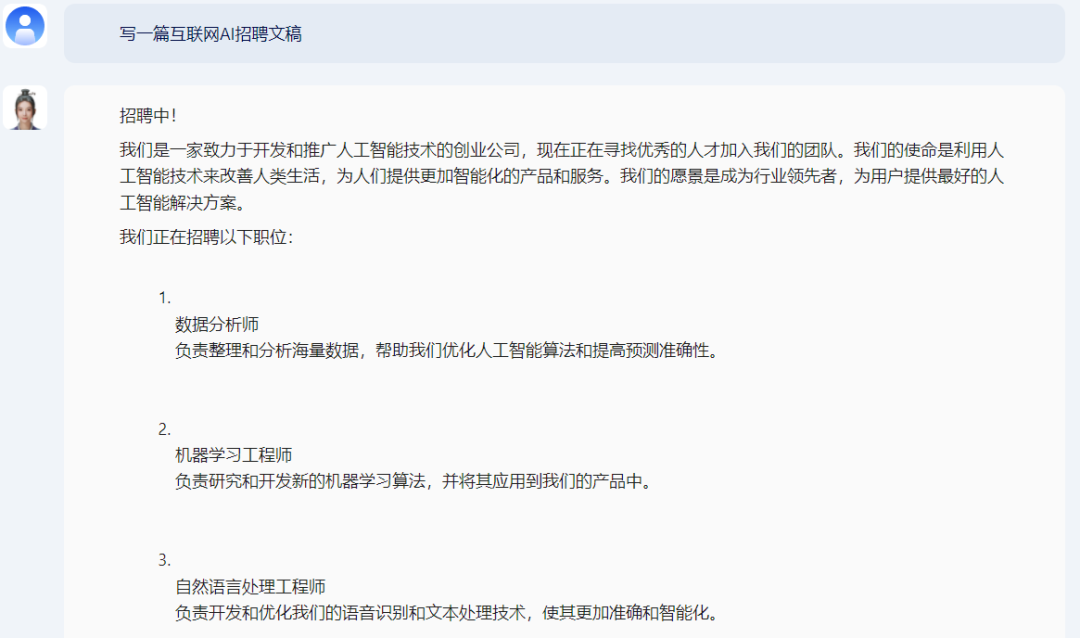

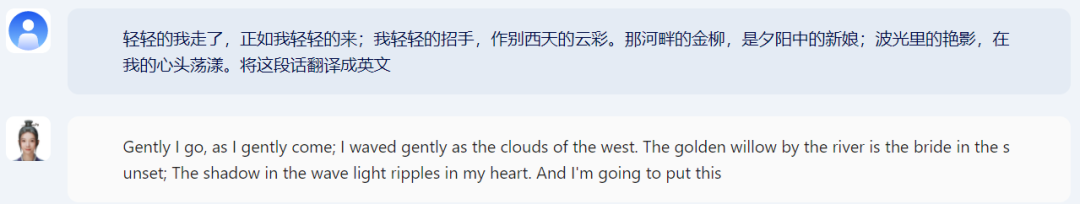

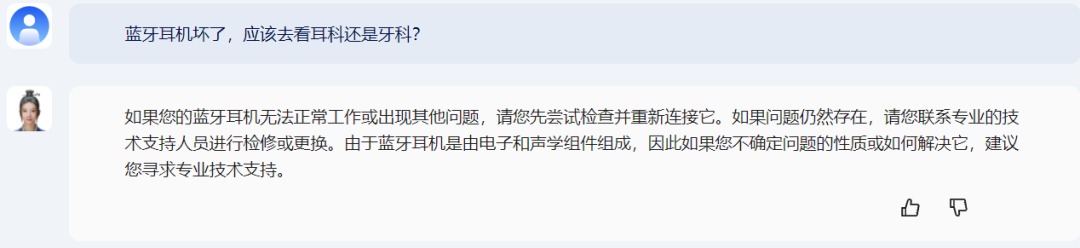

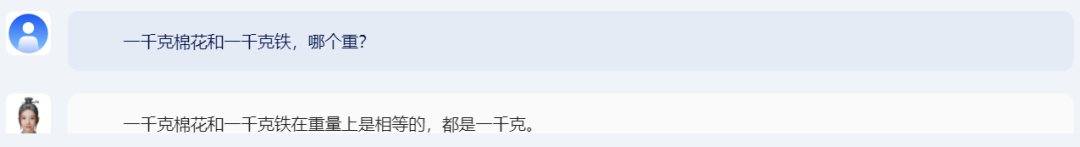

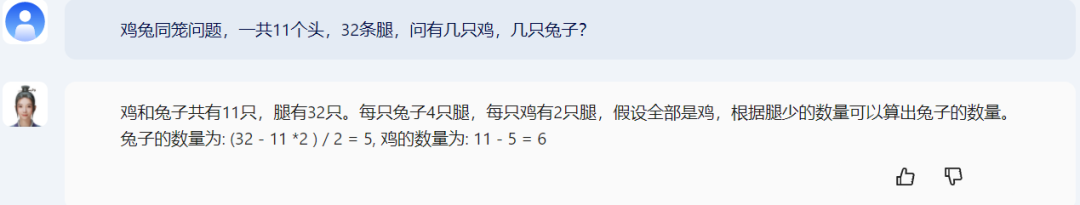

大会上,中国科学院自动化研究所(以下简称自动化所)还进行了现场演示,演示效果得到大家的一致好评,现场环节,观众还提出了自己问题,紫东太初都对答如流。例如,现场观众要求「生成竹林图片,中国国画风格」。从现场来看,紫东太初生成的竹林图片还不错。除了现场演示外,机器之心也上手测试了紫东太初 2.0,下面我们看看这个全模态大模型到底有哪些能力。首先让紫东太初 2.0 做一段简短的自我介绍,并获知了它的数据日期:接下来,机器之心从文本创作、知识问答、图文音理解、3D 理解、信号分析等多个方面对紫东太初 2.0 进行了全方位的测评。首先考察紫东太初 2.0 的文学创作能力。毋庸置疑,创作能力是每个对话大模型都要具备的重要能力之一,无论是生成诗歌、散文、剧本等。首先要求紫东太初「创作一篇关于夏天的散文,200 字」。从结果来看,紫东太初 2.0 的文笔还是不错的,字数也符合要求。紫东太初 2.0 帮助招聘人员写招聘材料也不在话下,它能把公司的大体情况,职位要求都写的很清楚,以后写招聘文案的活可以放心的交给它了:文本创作能力对大模型来说是件很容易的事,接下来考察紫东太初 2.0 的知识问答能力,看它能否准确理解用户输入的问题语境,并实时地做出对应的知识性问答。如今的大模型不仅要具备通用能力,还要有多样化的垂直专业能力,回答专业范畴内的问题(比如医学、天文地理、影视、哲学等等)。紫东太初 2.0 在这方面也做得很好:此外,紫东太初 2.0 具备多语言能力,可以处理多语言任务,包括中文、英文、法文等。那么是否具备译者的基本能力呢?我们先让紫东太初 2.0 翻译了《再别康桥》节选片段,结果来看还不错。接下来,我们在将问题难度提高,看看紫东太初 2.0 逻辑推理能力。测试下来,结果显而易见,它的头脑还是相当清醒的。对于蓝牙耳机坏了等问题,紫东太初没有陷入圈套,给出了正确的结果:大模型是否实用的一个重要方面在于它的数理能力,因此数理推算是测评必不可少的内容。经典的鸡兔同笼问题,紫东太初轻松拿下:紫东太初在图文音理解能力方面怎么样呢?这也难不倒这个大模型,例如生成一张小狗的图像,一眨眼的功夫,一张可爱的小狗就出现在眼前:难度加大,这次我们让它生成白色的小狗,这也不在话下,然后我们接着问图中几只小狗,模型都能回答正确:然后,我们上传一段音乐,让紫东太初 2.0 进行识别,结果也都准确:除此以外,紫东太初还能进行 3D 理解、信号分析。如下是室内 3D 点云图,将点云数据上传 ,模型就能基于点云数据的 3D 场景进行理解和物体感知,例如你可以问点云中包含什么物体,模型都能回答:

紫东太初还支持信号鉴别与知识交互,可借助模型快速掌握信号基本来源及参数等。输入信号,紫东太初给出了信号名称、带宽、赫兹等重要信息:最后考察一下紫东太初 2.0 多模态对话能力。我们输入一张狼的图片,以及狗叫声,问图片和声音是不是对应同一种动物。之后,我们继续测试:输入一张图书管和汽车喇叭声音,问这段声音有没有可能出现在这个场景中,紫东太初回答正确(这也是现场 Demo 展示的,亲测一下,结果也是正确的):一番测试下来,紫东太初 2.0 各项能力还是很能打的。历经 1.0,紫东太初 2.0 进入全模态发展阶段回望 2008 年,自动化所团队开始单独攻关图像、文本、音频技术;2020 年 1 月,他们开始转向多模态人工智能大模型研究,研发紫东太初大模型;2021 年 9 月,紫东太初 1.0 作为全球首个千亿参数三模态大模型正式发布。如今,紫东太初 2.0 全模态大模型已经发布了。

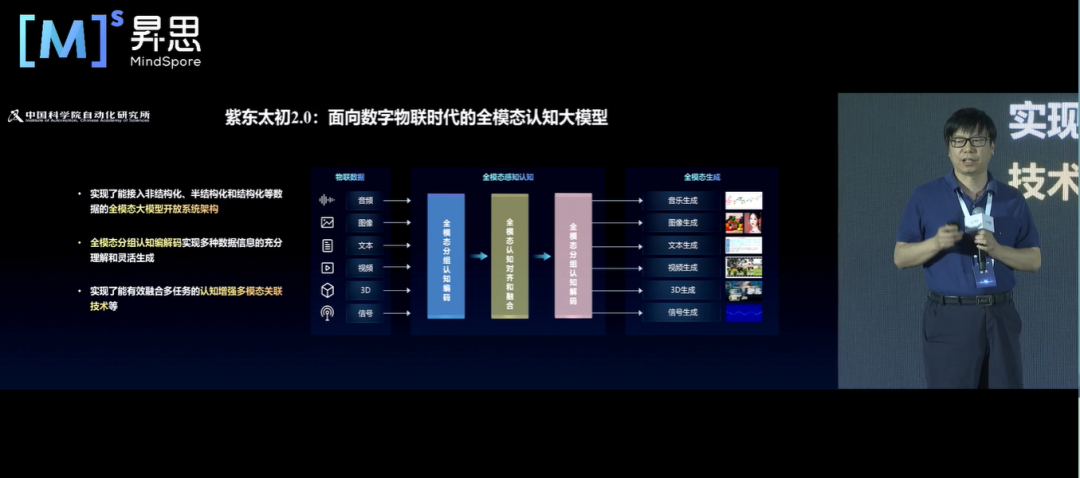

大家都了解,在数字物联时代,除了我们人类自身产生的语音、图像、文字等数据外,还有机器产生的大量结构化和非结构化数据,例如摄像头、医学影像、力触觉、工业传感信号等。针对数字物联时代的新需求与新趋势,紫东太初 2.0 诞生了。从技术架构上实现了结构化和非结构化数据的全模态接入。面对全模态数据,紫东太初 2.0 率先实现了认知增强的多模态关联,在全模态理解能力、生成能力和对齐能力上实现了跃升。- 首先,紫东太初 2.0 可以实现结构化和非结构化数据的全模态开放式接入;

- 其次,紫东太初 2.0 可以全模态分组认知编解码,实现多种数据信息的充分理解和灵活生成;

- 最后,紫东太初 2.0 实现了有效融合多任务的认知增强多模态关联技术等。

由此,紫东太初 2.0 打通了感知、认知乃至决策的交互屏障,具有全模态能力涌现,使人工智能进一步感知世界、认知世界,从而延伸出更加强大的通用能力,深入贯通多模态人工智能行业应用。目前,由自动化研究所牵头打造的多模态人工智能产业联合体已吸纳产学研界近 70 家成员单位。发布至今,紫东太初大模型已经在神经外科手术导航、短视频内容审核、法律咨询、医疗多模态鉴别诊断、交通违规图像研读等领域被广泛应用。此外,基于紫东太初大模型,团队还打造了面向行业应用的紫东太初开放服务平台。平台只需少量行业样本数据,即可通过低代码一站式开发,产出自主可控的行业相关大模型,大大提升开发效率,普惠千行百业。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com