- 长臂猿-企业应用及系统软件平台

专注AIGC领域的专业社区,关注OpenAI、百度文心一言等大语言模型(LLM)的发展和应用落地,关注LLM的基准评测和市场研究,欢迎关注!

随着ChatGPT、Midjourney等生成式AI产品的火爆出圈,在全球范围掀起AI大模型开发浪潮。国内的百度、华为、阿里、中科院、智源人工智能研究院、清华、北大、复旦等,各大科技公司、学术研究机构、高校等相继发布了大模型产品,开启“百模大战”时代。

这使得人们的关注焦点不再是中国何时能造出“ChatGPT”,而是国产大模型能否迎头赶上并实现弯道超车,打造具有自主知识产权的AI大模型。

下面「AIGC开发社区」对国内典型的大模型进行盘点,适用于金融、科技、电商、医疗、法律等行业。其中有多个是由知名高校、学术机构的开源项目并允许商业化,方便企业、个人开发者实现场景化落地打造属于自己的生成式AI产品。

百度——文心一言

文心一言是百度打造的全新一代知识增强大语言模型,具备多轮对话、文学创作、多模态生成、数理逻辑推算等技术特性,可以高效便捷地帮助人们获取信息、知识和灵感。

例如,写一篇太空旅行的市场分析报告;帮我画一枝晶莹剔透的牡丹花;量子计算机能帮移民火星吗?

体验地址:https://yiyan.baidu.com/welcome

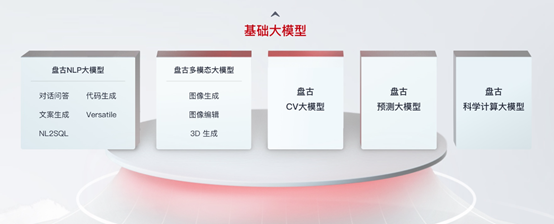

华为——盘古大模型

华为盘古大模型由CV,NLP,多模态,预测和科学计算5大基础模型组成,可实现文本生成、图片生成、代码生成、图片理解、气象预测、智能助手打造等多种功能。

华为盘古大模型作为通用AI预训练模型,可以广泛应用于矿山、药物分子、铁路、气象、海浪、制造等领域,提供智能化的解决方案。

体验地址:https://www.huaweicloud.com/product/pangu.html

阿里巴巴——通义大模型

通义大模型是阿里大模型的统一品牌,覆盖语言、听觉、多模态等领域,致力于实现接近人类智慧的通用智能,让AI从“单一感官”到“五官全开”。

目前,阿里通过通义大模型打造了通义千问、通义万相和通义听悟3款生成式AI产品。

体验地址:https://tongyi.aliyun.com/

科大讯飞——星火大模型

科大讯飞推出的新一代认知智能星火大模型,拥有跨领域的知识和语言理解能力,能够基于自然对话方式理解与执行任务,包括语言理解、知识问答、逻辑推理、数学题解答等。

星火大模型从海量数据和大规模知识中持续进化,实现从提出、规划到解决问题的全流程闭环。

体验地址:https://xinghuo.xfyun.cn/

清华大学——ChatGLM-6B

ChatGLM-6B是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。

ChatGLM-6B使用了和ChatGPT 相似的技术,针对中文问答和对话进行了优化。经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 已经能生成相当符合人类偏好的回答。

开源地址:https://github.com/THUDM/ChatGLM-6B

智源人工智能研究院——悟道·天鹰

悟道·天鹰(Aquila) 语言大模型是首个具备中英双语知识、支持商用许可协议、国内数据合规需求的开源语言大模型。

Aquila系列模型的中文语料来自智源多年积累的中文数据集,包括来自1万多个站源的中文互联网数据(其中99%以上为国内站源),以及获得国内权威机构支持的高质量中文文献数据、中文书籍数据等。仍在持续积累高质量、多样化的数据集,并源源不断加入Aquila基础模型后续训练中。

Aquila系列模型的源代码基于 Apache 2.0 协议,模型权重基于《智源Aquila系列模型许可协议》,使用者在满足许可限制的情况下,可用于商业目的。

开源地址:https://github.com/FlagAI-Open/FlagAI/tree/master/examples/Aquila

达观数据——"曹植"垂直大预言模型

"曹植 "作为垂直专用的国产大语言模型,具有长文本、垂直化和多语言的特点,通过并联多种模型和知识图谱,曹植大模型支持多种语言长文本的自动化写作和多语种翻译等功能,全方位赋能长文档写作、机器翻译、语义分析审核、知识问答、text-to-SQL 等场景,可针对不同行业、领域的文案需求,进行深度优化和个性化定制。

"曹植 " 可准确完成多类型、复杂结构的长文本写作,自动起草多种类型的文档,同时具有自动排版、智能纠错、文本润色、自动生成摘要等特色功能。还将实现多模态内容生成,如长文档中的表格、图表、图片等;支持中文、英文、法语、德语、日语、韩语等数十种语言的写作。

体验地址:http://www.datagrand.com/products/aigc/

上海人工智能实验室——书生·浦语(InternLM)

InternLM是在过万亿 token数据上训练的多语千亿参数基座模型。通过多阶段的渐进式训练,InternLM 基座模型具有较高的知识水平,在中英文阅读理解、推理任务等需要较强思维能力的场景下性能优秀,在多种面向人类设计的综合性考试中表现突出。

在此基础上,通过高质量的人类标注对话数据结合 RLHF 等技术,使得 InternLM 可以在与人类对话时响应复杂指令,并且表现出符合人类道德与价值观的回复。

开源地址:https://github.com/InternLM/InternLM

百川智能——baichuan-7B

Baichuan-7B是由百川智能开发的一个开源可商用的大规模预训练语言模型。基于 Transformer 结构,在大约 1.2 万亿 tokens 上训练的 70 亿参数模型,支持中英双语,上下文窗口长度为 4096。在标准的中文和英文 benchmark(C-Eval/MMLU)上均取得同尺寸最好的效果。

开源地址:https://github.com/baichuan-inc/baichuan-7B

北京大学——ChatLaw

ChatLaw法律大模型目前开源的仅供学术参考的版本底座为姜子牙-13B、Anima-33B,使用大量法律新闻、法律论坛、法条、司法解释、法律咨询、法考题、判决文书等原始文本来构造对话数据。

开源地址:https://github.com/PKU-YuanGroup/ChatLaw

哈尔滨工业大学——本草

本草大预言模型经过中文医学指令精调/指令微调(Instruct-tuning) 的LLaMA-7B模型。通过医学知识图谱和GPT3.5 API构建了中文医学指令数据集,并在此基础上对LLaMA进行了指令微调,提高了LLaMA在医疗领域的问答效果。

开源地址:https://github.com/SCIR-HI/Huatuo-Llama-Med-Chinese

云知声——山海

山海大模型是最新一代认知智能大模型,拥有丰富的知识储备,涵盖科学、技术、文化、艺术、医疗、通识等领域。与她对话即可获取信息、知识和灵感,是人类的良师益友,也是灵动强大的智能助理。

体验地址:https://shanhai.unisound.com/

OpenBMB——CPM-Bee-10B

OpenBMB开源社区由清华大学自然语言处理实验室和智源研究院语言大模型加速技术创新中心共同支持发起。

CPM-Bee-10B是完全开源、可商用的中英双语基础模型,参数容量达百亿级,利用Transformer自回归架构,在万亿级代币的海量语料库上进行了预训练,拥有卓越的基础能力。

OpenBMB系统提供了全面的工具和脚本生态系统,用于高性能预训练、适配、压缩、部署和工具开发。CPM-Bee作为基础模型,附带所有必要的工具脚本,使开发人员能够有效地利用和探索高级功能。

开源地址:https://huggingface.co/openbmb/cpm-bee-10b

中国科学院自动化研究所——紫东·太初

紫东·太初跨模态通用人工智能平台是由中国科学院自动化研究所研发的以多模态大模型为核心、基于全栈国产化基础软硬件平台,可支撑全场景AI应用。依托面向超大规模的高效分布式训练框架,自动化所构建了具有业界领先性能的中文预训练模型、语音预训练模型、视觉预训练模型,并开拓性地通过跨模态语义关联实现了视觉-文本-语音三模态统一表示,构建了三模态预训练大模型,赋予跨模态通用人工智能平台多种核心能力。

紫东·太初兼具跨模态理解和生成能力,具有了在无监督情况下多任务联合学习、并快速迁移到不同领域数据的强大能力。对更广泛、更多样的下游任务提供模型基础支撑,达成AI在如视频配音、语音播报、标题摘要、海报创作等更多元场景的应用。

开源地址:https://gitee.com/zidongtaichu/multi-modal-models

虎博科技——TigerBot

TigerBot是一个多语言多任务的大规模语言模型(LLM)。根据 OpenAI InstructGPT 论文在公开 NLP 数据集上的自动评测,TigerBot-7B 达到 OpenAI 同样大小模型的综合表现的96%。

开源地址:https://github.com/TigerResearch/TigerBot

360——智脑

360智脑是一个千亿参数大模型,涵盖十大能力数百项细分功能,目前已升级至4.0版本。360智脑具备十大核心能力,维度涵盖数百项细分功能,可覆盖大模型全部应用场景。

同时,360智脑在多模态等关键能力上完成迭代,在国内首发大模型定制AI数字人及文生视频功能,接入360旗下全端产品,重塑人机协作新范式。

体验地址:https://ai.360.cn/

上海交通大学——K2

K2是一个地球科学的开源大预言模型。首先通过收集和清理的地球科学文献(包括地球科学开放获取论文和维基百科页面)对 LLaMA 进行进一步预训练,然后使用知识密集型指令调优数据(GeoSignal )。

初步评估采用GeoBenchmark(由NPEE和AP

Test on Geology、Geography、Environmental

Science组成)作为基准。与具有相似参数的几个基线模型相比,K2 在客观和主观任务上的表现优于基线。

开源地址:https://github.com/davendw49/k2

智媒开源研究院——MediaGPT

MediaGPT(曾用名Media LLaMA)首先在大规模自媒体语料上进行连续预训练,系统地学习自媒体的知识体系。然后,借助ChatGPT收集了一批关于抖音运营、短视频创作、巨量千川投放、直播运营和直播话术技巧等领域知识问题的分析和回答,并利用这些数据对模型进行指令微调,使模型习得如何将自媒体知识应用到实际场景中。

开源地址:https://github.com/IMOSR/MediaGPT

度小满——轩辕

轩辕是国内首个开源的千亿级中文对话大模型,同时也是首个针对中文金融领域优化的千亿级开源对话大模型。

轩辕在BLOOM-176B的基础上针对中文通用领域和金融领域进行了针对性的预训练与微调,它不仅可以应对通用领域的问题,也可以解答与金融相关的各类问题,为用户提供准确、全面的金融信息和建议。

开源地址:https://huggingface.co/xyz-nlp/XuanYuan2.0

东北大学——TechGPT

TechGPT是“东北大学知识图谱研究组”发布的垂直领域大语言模型。TechGPT还具备了对计算机科学、材料、机械、冶金、金融和航空航天等十余种垂直专业领域自然语言文本的处理能力。

目前,TechGPT通过提示和指令输入方式的不同,支持单轮对话和多轮对话,涵盖了领域术语抽取、命名实体识别、关系三元组抽取、文本关键词生成、标题生成摘要、摘要生成标题、文本领域识别、机器阅读理解、基础常识问答、基于上下文的知识问答、建议咨询类问答、文案生成、中英互译和简单代码生成等多项自然语言理解和生成能力。

开源地址:https://github.com/neukg/TechGPT

本文素材来源各大厂商官网,如有侵权请联系删除

END