- 长臂猿-企业应用及系统软件平台

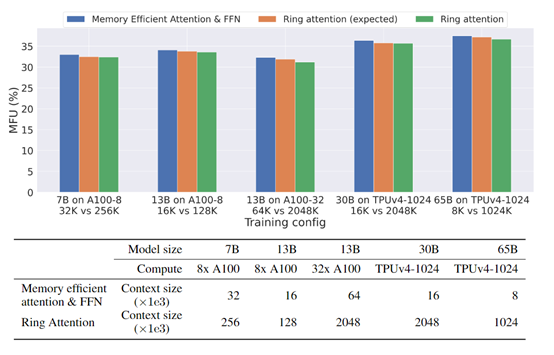

来源 | AIGC开放社区 大语言模型(LLM)在生成文本内容方面非常强,但在理解、生成视频、图像等方面略显不足。尤其是在 Sora 一夜爆红之后,让人们意识到未来主流模型一定是文本 + 音频 + 图像 + 视频的多模态生成、理解功能。 因此,加州大学伯克利分校的研究人员开源了一种训练数据更多、理解能力更强的基础模型——大世界模型(Large World Model,简称“LWM”)。 LWM 是一种通用的多模态自回归模型,与前不久谷歌发布的 Gemini 1.5 一样,一次性可精准解答 100 万 tokens 的视频、文本,例如,LWM 可以正确回答 1 小时 YouTube 视频中包含 500 多个视频片段的问题。 开源地址:https://github.com/LargeWorldModel/LWM 论文地址:https://arxiv.org/abs/2402.08268 huggingface:https://huggingface.co/LargeWorldModel 此外,LWM 可以精准检索 100 万 tokens 文本中的内容,同时与 Sora 一样具备文本生成视频、图像的能力。整体性能非常强悍,目前在 github 获得超 6000 颗星,有纯文本、视频、图像等多个版本模型可使用。 在传统的注意力机制中,例如,Transformer 架构中使用的自注意力,模型需要计算序列中每个元素对于其他所有元素的注意力得分,这就会面临两大难题。 1)内存需求上升:模型需要存储每一对元素间的注意力得分,会随着序列长度的增加而急剧增加内存需求。 2)计算复杂度:当序列很长时,会导致巨大的算力负担。 LWM 的核心技术是通过 Ring Attention(环形注意力)在长序列上进行扩展训练,并使用 Books3 数据集从 32000 扩展到 100 万标记,而无需消耗额外的内存、算力并降低计算复杂度。 Ring Attention 论文地址:https://arxiv.org/abs/2310.01889 尽管 Ring Attention 减少了每个片段的直接交互范围,但仍然允许信息在序列中传递,保持了模型对长距离依赖的捕捉能力,减少了长序列的处理损失度。 这也是 LWM 能处理高达 100 万 tokens 数据的原因之一。 RingAttention 是通过使用循环结构来扩展,注意力机制的上下文大小。传统的注意力机制在计算上下文相关性时,通常只关注序列中相对较近的位置。 但在处理长序列时,远距离的上下文信息也可能对模型的理解和推理能力至关重要。RingAttention 通过引入环形结构来解决这个难题。 具体来说,使用了一种环形缓冲区来存储先前计算的注意力权重。模型可以在计算当前位置的注意力时,考虑到之前计算的位置的信息,从而无限扩展了上下文范围,主要功能模块如下。 环状分组:该模块将输入序列划分为多个环,每个环中的位置与其他环中的位置之间进行相关性计算。通过这种划分方式,可以有效降低计算复杂度。 环内注意力:在每个环内,该模块计算位置之间的相关性,并根据相关性的权重对位置进行加权。这样,每个位置都可以获得来自同一环的其他位置的信息。 环间注意力:这个模块负责计算不同环之间的相关性。通过将每个环的表示与其他环的表示进行比较,计算它们之间的相关性,这种跨环的交互有助于在不同环之间传递信息。 环间投影:在环间注意力之后,该模块将每个环的表示投影到一个共享的表示空间中,有助于进一步整合不同环之间的信息。 通过这些关键模块的协同工作,Ring Attention 实现了对长序列的高效处理和建模,并为训练大规模模型提供了高效方法。 第一阶段是语言模型的预训练, 主要扩展语言理解的上下文长度。LWM 使用了 Books3 数据集, 从 32,000 tokens 逐步扩展到 100 万 tokens,同时针对长序列的聊天任务进行了微调。 第二阶段是多模态的预训练, 将视觉信息整合到语言模型中。LWM 使用了大量包含图像和视频的公开数据集, 例如,LAION-2B、COYO-700M、WebVid10M 等。 同时训练图像 - 文本、视频 - 文本等多种对齐格式。视频以每秒 4 帧的速度提取关键帧,特别针对 32K、128K 和 1M tokens 长度进行了优化训练。

李一舟爆雷或牵连AI课程行业;谷歌联合创始人被控过失杀人;黄仁勋身家冲至全球21名,称赞华为;阿里效仿Sora作息?| AI周报

贾扬清质疑 Groq CEO “其芯片价格接近免费”说法,前员工出来实锤:根本不切实际!

你也「在看」吗? 👇