- 长臂猿-企业应用及系统软件平台

发挥想象

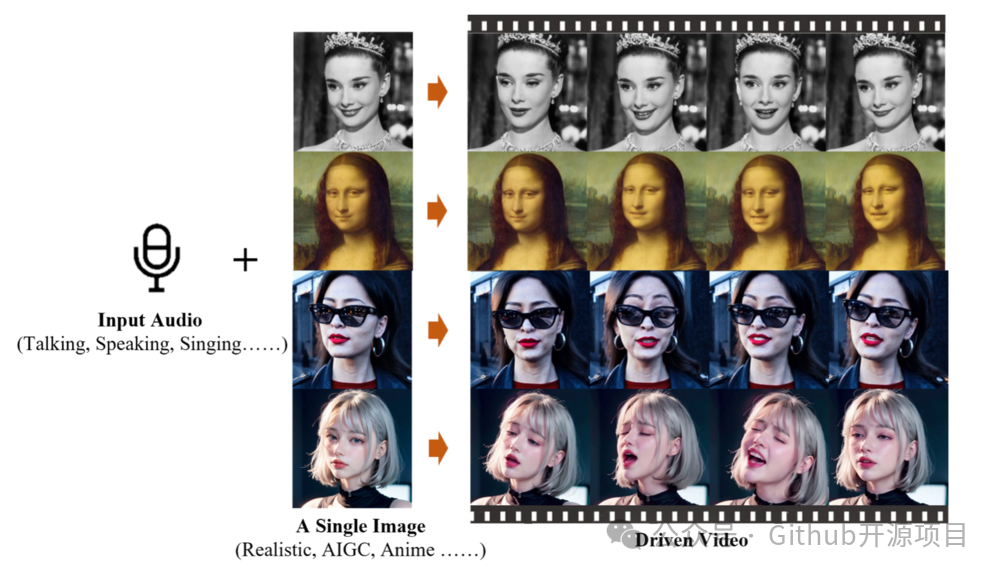

电视剧里的高启强开始给你讲法律,或者是蒙娜丽莎突然唱起了《Perfect》,这画面太美我不敢想。

而且阿里说了,不管是什么样的音频、语速、图像,EMO都能搞定,这操作简直了,B站的鬼畜视频估计得升级换代了。

技术层面

这技术牛在哪儿?

用官方的话说,就是"一种富有表现力的音频驱动的肖像视频生成框架"。简单来说,就是通过声音把照片变成视频,而且还能根据音频的长度随意调整视频时长,想要多长有多长。

技术怎么实现的?

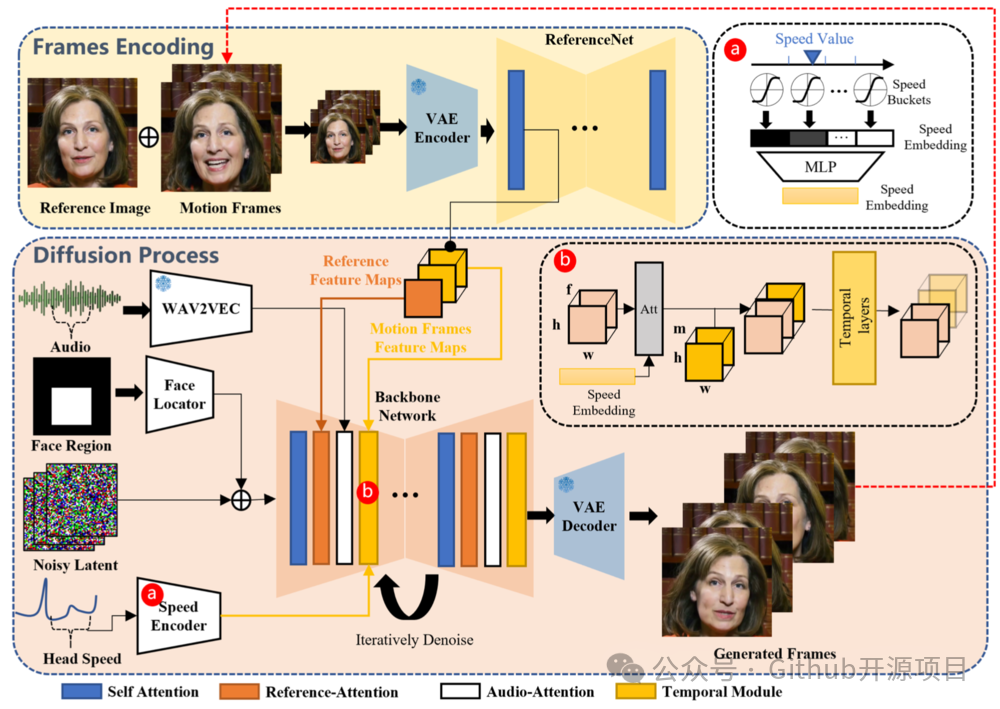

核心是个叫做Audio2Video的扩散模型,大致流程分三步:先从参考图像提取特征,再通过音频编码器处理音频嵌入,最后通过一个主干网络去噪,生成视频。听起来挺复杂的,但结果就是能让照片里的人按照你的音频唱歌跳舞。

另一方面

不过,阿里也不是只有这个EMO。之前还推出过Qwen-VL模型,能够处理图像和文本,生成新的内容。看来,阿里在AI这块是下了一番苦工。

最后

链接地址:https://www.j301.cn/blog/github_ai_tool_emote_portrait_alive.html

点击下方公众号,回复关键字:github,获取Github开源项目合集!

点分享

点收藏

点点赞

点在看