研发具有创新性的ChatGPT究竟给其背后的公司OpenAI带来了什么?据The information报道,ChatGPT的诞生不仅给OpenAI带来了前所未有的关注度,吸引了微软“多年、数十亿美元”投资扩展。更为不容忽视的是,对于这家开发了ChatGPT的初创公司而言,因为大模型需要耗费巨大的算力资源和数据,以及其背后运营也要付出不菲的开销,仅是在2022年,OpenAI总计损失达到了5.4亿美元,与之形成鲜明对比的则是其产生的收入只有2800万美元。那要问OpenAI为什么会亏得这么厉害,想必不少人都会直接说一句:不砸钱必定搞不出大模型。其实自去年11月OpenAI推出ChatGPT以来,外界对于ChatGPT的运行成本持以高度好奇。一直以来,OpenAI并没有直接对外公开过具体的开销成本。不过,很多网友还是找到了蛛丝马迹,推算出了大概。据悉,最早在2020年,OpenAI使用的是Google云服务,彼时花费高达7500万美元,直到后来使用微软的Azure平台,才逐渐减少云服务托管方面的支出。然而,此前微软曾在博客上透露,「为支持OpenAI模型的落地,其不仅使用了上万颗GPU,也花费了数亿美元」:当时为了支持OpenAI训练大模型,微软开发了一套新的Azure人工智能超级计算技术,也在Azure中建立超级计算资源,这些资源的设计和专用性使OpenAI能够训练一套日益强大的AI模型。为了训练出这套模型,微软在基础设施中使用了数以千计的英伟达人工智能优化GPU,它们被连接在一个高吞吐量、低延迟的网络中,该网络基于英伟达量子InfiniBand通信,用于高性能计算。对此,促成微软和OpenAI合作的关键人物——负责战略合作伙伴关系的微软高级主管Phil Waymouth 表示,OpenAI训练其模型所需的云计算基础设施的规模是前所未有的,比业内任何人试图建立的网络GPU集群都要大得多。后来据彭博社报道,微软在该项目上已经花费了数亿美元。正是基于此,微软的Azure云如今托管ChatGPT项目,这样OpenAI就不必投资物理机房。有外媒曾分析过,考虑到微软目前的收费标准,一个A100 GPU 的费用是每小时3美元,ChatGPT上生成的每个词的费用是0.0003美元。至少有八个GPU在使用,才能在一个ChatGPT上运行。因此,按照ChatGPT生成的回复通常至少有30个单词来计算,只要ChatGPT回复一次,OpenAI公司将花费近1美分。通过这样的估算,OpenAI每天可能要花费至少10万美元或每月300万美元的运行成本。此外,研究公司SemiAnalysis的首席分析师Dylan Patel曾在接受采访时表示,当使用ChatGPT写求职信、生成课业规划和在约会应用上润色个人简介等操作时,每天可能会烧掉OpenAI多达70万美元,每次查询要花掉36美分。这是因为ChatGPT需要大量的计算能力来对用户的提示词做出快速响应。与此同时,从算力角度来看,有分析表明,目前一个NVIDIA A100 GPU可以在大约6毫秒内运行一个30亿个参数的模型。按照这个速度,单个NVIDIA A100 GPU大约需要350ms秒才能在ChatGPT上输出一个单词。由于ChatGPT-3.5拥有超过1750亿个参数,且目前ChatGPT每秒大约能够输出15-20个英文单词,所以如果用户想要获得单个查询的输出结果,背后需要至少8个A100 GPU来执行操作。其实,大模型无论是闭源还是开源,非常耗钱这件事,只要从事AI模型方面的从业者,心里都有数。此前,Meta在发布开源的LLaMA大模型时,在论文中也提到,“当训练一个65B参数的模型时,我们的代码在2048 A100 GPU和80GB的内存上处理大约380个token /秒/GPU。这意味着在我们包含1.4T标记的数据集上进行训练大约需要21天。”来源:https://arxiv.org/pdf/2302.13971.pdf为此,也有微博博主@BohuTANG做了一下换算:2048个GPU*21*24*1$ ~ 100w刀,这还是确定数据集和参数后一次的训练成本。毋庸置疑,参数量更大、数据集更广的ChatGPT即使没有透露出具体的训练、运行成本,只是想想,也不会低。

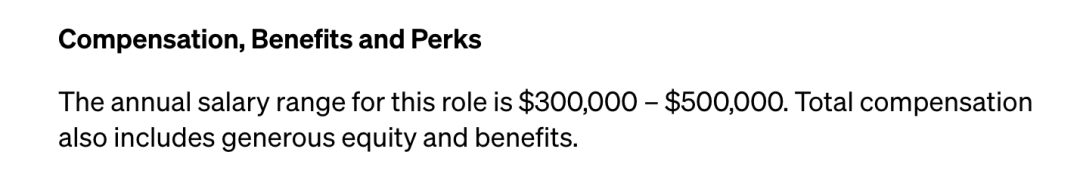

当然,OpenAI支出与收入之间形成巨大落差的根源,不仅是训练语言模型的高成本,还有一部分花在了聘请昂贵的技术人才上。今年2月,有外媒曾报道,OpenAI已经从Google挖走了超过12名AI方面的技术专家。而就在OpenAI推出ChatGPT之前,便有至少5名前Google研究人员参与其中。其中,Google前研究人员Barret Zoph、Liam Fedus、Luke Metz、Jacob Menick和Rapha Gontijo Lopes等人都出现在了OpenAI官宣ChatGPT博客文章的致谢部分。与此同时,OpenAI联合创始人、首席科学家Ilya Sutskever也曾是Google Brain团队成员。他曾在2012年与Alex Krizhevsky、Geoffrey Hinton共同提出了著名的AlexNet,推动了深度学习的革命。2015年,他从Google离职,于次年加入了OpenAI。现如今,他也是ChatGPT、GPT-4背后最为重要的主导者之一。招揽这些顶尖的人才,OpenAI除了营造舒适的学术、研究、商业氛围之外,薪酬、福利待遇也是必不可缺的。据纽约时报报道,2016年,OpenAI向Ilya Sutskever支付了超过190万美元。另外,根据OpenAI官方的招聘信息显示,其在招的职位超过40个,普通的ChatGPT软件工程师、机器学习研究科学家的薪资水平在20万美元 - 37万美元(约138.2万-255.7万元人民币)。主管的级别更高一些,薪资也会随之提升,譬如ChatGPT移动端工程主管的薪酬在30万美元至50万美元(约207.4万-345.6万元人民币)。相较而言,如果是直接挖过去的人才,预估薪酬会更高一些,毕竟能力和薪酬往往成正比。当然为了保证OpenAI可持续研究AI的脚步,有消息人士透露,OpenAI CEO Sam Altman可能打算在未来几年内筹集高达1000 亿美元的资金,用于实现公司创建通用人工智能(AGI)的目标。现实来看,随着ChatGPT用户量的增多,支出将水涨船高。一方面,为支持语言模型和训练新版本,OpenAI预期在云计算方面投入会比以往更大。

另一方面,随着Reddit和StackOverflow、Twitter等平台纷纷发声,想要拒绝被“白嫖”,欲向AI模型公司收取访问器先前免费数据集的费用。此前据《纽约时报》报道,埃隆·马斯克在发现OpenAI每年只支付200万美元后终止了OpenAI对Twitter数据集的访问。因此,在新的一年里,要想获取更多新的数据集,OpenAI的数据成本无疑也将飙升。最后,虽然在今年年初,微软表示,将向OpenAI投资数十亿美元。不过,据The Verge透露,作为这项投资的一部分,微软在前期有权获得OpenAI 75%的利润,直到它收回投资的100亿美元,以及微软早期投资该公司的额外30亿美元。随后当OpenAI的利润达到920亿美元后,微软获得OpenAI利润的比例降至49%。最后,当OpenAI的利润达到1500亿美元之后,OpenAI才能获得公司100%的股份。这期间,微软还获得了对OpenAI软件的优先访问权,使其能够将OpenAI的软件连同其利用OpenAI技术的人工智能产品一起转售给其Azure客户。为此,OpenAI亏损去年翻倍,也便不足为奇。不过,随着OpenAI推出ChatGPT Plus、API等付费服务逐渐走上“正轨”,OpenAI预计2023年的收入为2亿美元。也有一些投资者认为,ChatGPT在未来的某一个时点,可能成为该公司的赚钱利器。而当下,OpenAI至少已经实现了在大模型领域处于领跑地位。https://arxiv.org/pdf/2302.13971.pdfhttps://www.businessinsider.com/chatgpt-openai-google-ai-employees-hired-report-2023-2https://www.artisana.ai/articles/openai-suffers-usd540m-loss-in-2022-contemplates-usd100b-more-to-conquer-aihttps://www.theverge.com/2023/1/23/23567448/microsoft-openai-partnership-extension-aihttps://www.ciocoverage.com/openais-chatgpt-reportedly-costs-100000-a-day-to-run/来源:CSDN(ID:CSDNnews)整理 | 屠敏

免责声明:所载内容来源于互联网,微信公众号等公开渠道,我们对文中观点持中立态度,本文仅供参考、交流。转载的稿件版权归原作者和机构所有,如有侵权,请联系我们删除。