—

未来的人工智能格局会被单一的通用 AI 模型所主导吗?

来源 / 投资实习所 (ID:startupboy )

作者 / StartupBoy

昨天在写最近 VC 疯狂投资的 AI 细分赛道这篇文章时,我提到了我所认知到的 AI 在当下的一个状况:对于那些越来越专业的细分领域,仅靠某个单一的基础模型,还很难实现非常完美的解决方案,它可能需要多个模型(封闭或者开源的模型)共同来支持,甚至需要更多外部专业的数据、API 等能力的补充。VC 们对这个赛道的大量投资,除了基于这样一个现状外,另外两个基本的假设我觉得已经成立:一个就是未来每个企业都需要至少 2 个或者以上的 LLM 模型,这个观点 LinkedIn 和 Greylock 创始人 Reid Hoffman 也在前段时间分享过,他认为未来一定会有多个大型模型提供方;另一个则是 AI 的 Android 时刻已经开启。这一切,本质上还是来自大量创业者(或者说大量开发者)探索与实践的推动,只要每天看看 Github 上大量的各种开源模型的进步,以及 AI 领域最新的各种研究论文,就能非常明显的感受到这种氛围。我在昨天的文章里也分享了投资机构 Madrona 在这块最新的一些研究观点和案例。而在两天前,由 Samaya AI 联合创始人 Maithra Raghu(他之前也是 Google Brain 的研究科学家)、Databricks 的联合创始人 Matei Zaharia 以及 Google 前 CEO Eric Schmidt,联合发表了一篇文章《Does One Large Model Rule Them All?》,我觉得是目前我读到关于 AI 预测最好也是最认同其观点的一篇文章。- 与(单一)通用 AI 模型不同的是,将会出现许多高实用性 AI 系统

- 这些人工智能系统的结构将很复杂,由多个人工智能模型、API 等提供支持

- 那些定义明确、高价值的工作流程将由专业 AI 模型完成而不是通用 AI 模型

前 Google 研究科学家、Facebook AI 总监以及阿里巴巴负责 AI 和数据这块的副总裁贾扬清在 LinkedIn 对这篇文章评论说:My two cents: model monopoly has never happened even once in the AI world, and especially deep learning. Shelf life of models is usually something up to 1 year. It is also due to the very awesome openness mindset of AI researchers.

模型垄断在人工智能世界中从未发生过一次,尤其是深度学习。模型的保质期通常长达一年,这也是由于人工智能研究人员非常令人敬畏的开放心态。

这与我在昨天的文章里分享的 Madrona 的研究结果也很类似:现在的开源模型与 OpenAI 等封闭模型之间的差距只有 6-18 个月的差距,在经过一些微调后,可以更进一步提高准确性。如果这些假设都成立,或许当下我们能做的事情就更多了?下面简单对这篇文章做了一下分享,如果有时间建议阅读一下英文版原文:https://maithraraghu.com/blog/2023/does-one-model-rule-them-all/在过去的10年里,人工智能不断取得进步,每一波新的发展浪潮都带来令人兴奋的新功能和应用。最大的此类浪潮无疑是最近兴起的单一通用 AI 模型,例如 LLMs,它可用于从代码生成到图像理解再到科学推理的各种任务。这些任务的执行具有如此高的保真度,以至于整个新一代的技术应用正在被定义和开发。虽然考虑其潜在影响令人兴奋,但这种巨大的成功确实让我们对未来的人工智能生态系统提出了一个非常令人不安的问题:未来的人工智能(AI)格局会被单一的通用 AI 模型所主导吗?

由少数(小于 5 个)实体所主导,每个实体都有一个大型的通用 AI 模型?

- 这些通用 AI 模型是否会成为推动所有重要的 AI 技术进步和产品的关键组成部分?

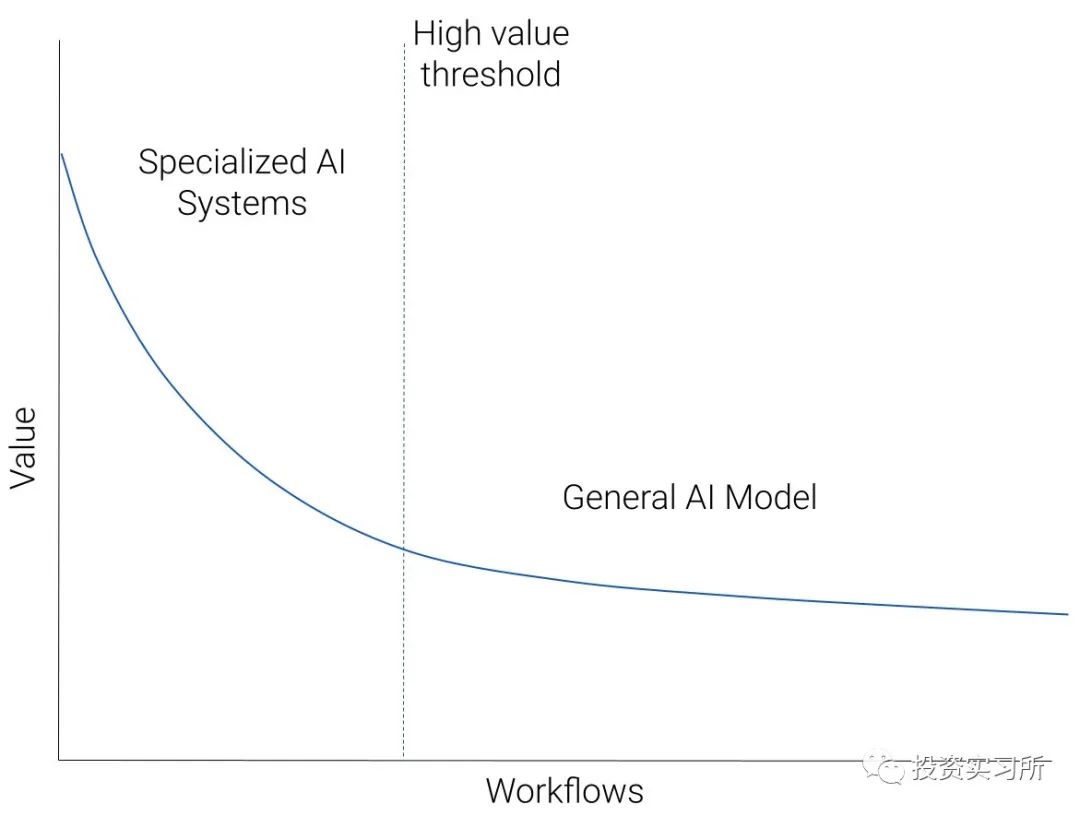

随着 ChatGPT 和 GPT-4 等模型的发布,改变了我们对 AI 能做什么的理解,以及开发这种模型的成本不断上升,这已经成为一种普遍的信念。我们可以用下面的图表来说明我们对人工智能生态系统的预测:想象一下,我们采用了所有适用于基于 AI 的解决方案的工作流程,并按照“价值”的降序排列它们。价值可能是收入潜力,或者仅仅是对用户的效用。会有一小部分价值非常高的工作流程,一个大的市场或大量的用户,有明确定义的痛点可以通过人工智能解决。什么是高价值工作流的案例?现在还处于非常早期阶段,但我们在编程助手、视觉内容创作、搜索和写作助手方面看到了令人兴奋的发展。那么,价值较低的工作流程的大量长尾呢?这些会比较难以定义,它们将由各种特定的需求来定义产生。比方说,通过分类对来自客户支持机器人的请求进行分类。我们预测,图中的左上角(高价值的工作流)将由专门的人工智能系统主导,而当我们沿着蓝色曲线向下移动到低价值的工作流时,通用人工智能模型将成为主导统治地位。咋一看,这个图看起来是反直觉有悖常理的。一些最先进的人工智能能力似乎来自通用模型。那么,为什么这些模型不应该在高价值的工作流中占主导地位呢?但考虑到生态系统接下来的演变可能,有许多重要因素支持这个图所展示的情景,我们将在下面详细展开。高价值的工作流程需要高质量,并激励任何的质量改进。任何应用于高价值工作流程的人工智能解决方案都会不断调整以提高质量。由于质量上的差距来自于工作流程的特定需求,这种调整就导致了专业化。专业化可以是直接调整工作流程的具体数据,或者(更有可能)开发多个专门的 AI 组件。我们可以通过目前用于自动驾驶汽车的人工智能系统来了解一个具体的例子。这些系统有多个 AI 组件,从规划组件,到检测组件以及数据标签和生成组件。(这里的更多细节,可以参考之前特斯拉在其 AI DemoDay 上的演示)。天真地用 GPT-4 这样的通用 AI 模型来取代这种专门的 AI 系统,会导致质量的灾难性下降。但是,战略性应用更高级的通用 AI 模型 GPT-(4+n),能不能完成这个工作流程?想象一下,GPT-(4+n) 已经发布,它具有非常有用的功能,包括自动驾驶;

我们无法立即替换整个现有的系统;

因此,我们找出 GPT-(4+n) 中最有用的功能,并考虑将其作为另一个组件添加进来,也许是通过 API 调用;

然后对这个新系统进行测试,不可避免地会发现质量上的差距;

存在解决这些差距的推动力,并且由于它们来自特定的工作流程(自动驾驶),因此开发了这个特定工作流程的解决方案。

- 最终结果可能是 API 调用被一个新的、专门的 AI 组件完全取代,或者用其他专门的组件进行了扩充。

虽然这个思想实验可能并不完全准确,但它说明了我们如何从一个通用的人工智能模型开始,然后对其进行实质性专业化以提高质量。这里我们可以总结得出,(1)质量对高价值的工作流程很重要,(2)专业化有助于提高质量。与质量考虑密切相关的是用户反馈的作用。有明确的证据表明,对高质量的人类 "使用 "数据(比方说偏好、说明、提示和回应等)进行仔细的调整,是推动通用 AI 模型能力的核心。比方说在 LLMs 中,RLHF(从人类反馈中强化学习)和对类似人类指令/偏好数据的监督学习等技术对于获得高质量的生成和指令行为至关重要。这一点在 InstructGPT 和 ChatGPT 中得到了明显的证明,现在也刺激了许多 LLM 的开发工作(例如 Alpaca、Dolly 以及 gpt4all)。同样,我们希望用户的反馈在推动人工智能在特定工作流程中的能力方面发挥关键作用。但是,有效地纳入这种反馈将需要对人工智能系统进行颗粒度的控制。我们不仅可能希望根据用户的反馈仔细调整基础模型(由于成本和访问受限,一般的通用 AI 模型很难做到),而且我们可能需要调整整个人工智能系统的结构,例如定义数据、人工智能模型和工具之间的交互。从工程(不同的微调方法、链接 API 调用、与不同的 AI 组件合作)、成本(大型模型适应成本高)和安全(参数泄漏、数据共享)的角度来看,为通用 AI 模型设置这种颗粒度的控制是具有挑战性的。总之,用户反馈所需的颗粒度控制,用专门的人工智能系统来实现要容易得多。许多高价值、特定领域的工作流程依赖于丰富的、专有的数据集。这些工作流程的最佳人工智能解决方案将需要在这些数据上进行训练。然而,拥有这些数据集的实体将专注于保护他们的数据护城河,不太可能允许第三方不受约束地访问。因此,这些实体将在内部或通过特定的伙伴关系建立专门用于这些工作流程的人工智能系统。这些将有别于通用的人工智能模型。与此相关的是,许多领域还利用专有知识,一种只有少数人类专家才了解的 "商业秘密"。比方说,支持台积电的尖端芯片制造技术,或顶级对冲基金使用的量化算法。利用这些专有知识的人工智能解决方案将再次在内部构件,专门用于这些工作流程。这些都是 "构建与购买 "计算的例子,这种计算在之前的许多技术周期中都发生过,并且在这一波浪潮中也会重现。人工智能模型的商品化(Commoditization of AI Models)在努力开发昂贵的专有模型(如 GPT-4)的同时,也在努力构建和发布人工智能模型(如 Llama),然后快速优化这些模型让其甚至可以在手机上运行。这些都是 (1) 基于成本的效用和 (2) 效率之间激烈的、持续的竞争的例子。这里的效率是指在保持效用的同时,使新的人工智能进步的成本降低的快速过程。这发生在几个关键属性上:人工智能领域在合作、已发表的研究和开源方面有很强的根基,从而导致(煞费苦心发现的)技术见解的知识传播速度加快;

由于更好的硬件、基础设施和训练方法,训练流行的人工智能模型的计算成本迅速下降;

收集、管理和开源数据集的努力有助于模型建设的民主化和提高质量。

对于我们目前最强大的模型,似乎有可能在竞争中获胜,从而导致这些模型的商品化。但这是否意味着所有大型通用人工智能模型都将被商品化?这取决于其它参与者,它是基于成本的效用。如果一个人工智能模型是有用的,但也是非常昂贵的,那么效率过程需要的时间会更长,因为前期成本越高,降低成本所需的时间就越长。- 如果成本增加一个数量级但效用收益递减,那么我们将再次看到商品化;

- 如果成本增加一个数量级并且效用成比例的提高,那么很可能会有少量成本非常高的通用模型未商品化。

这是很难预测的。未来的人工智能模型肯定有更大的空间来构建更大数量/类型的数据和增加的计算。如果实用程序也继续增加,我们将拥有一些昂贵的通用 AI 模型,用于如上图所示的大量多样、难以定义的工作流——为 AI 做的就像云为计算做的一样尽管人工智能的进步浪潮长达十年之久,但人工智能的未来看起来比过去更加多变!我们预计会出现一个丰富的生态系统,其中包含各种由不同 AI 组件提供支持的高价值、专业化 AI 系统,以及一些通用 AI 模型,支持多种多样的 AI 工作流程。